一、本文介绍

本文给大家带来的最新改进机制是 多尺度特征 提取和通道注意力机制DICAM, 深度Inception和通道注意力模块(DICAM) 主要用于用于增强水下图像的质量、对比度和色偏。所提出的DICAM模型考虑了水下图像的比例退化和不均匀色偏,从而提高图像的质量。通过在两个公开的水下图像增强数据集上的广泛实验,验证了提出的模型在全参考和无参考图像质量评估指标方面。

欢迎大家订阅我的专栏一起学习YOLO,购买专栏读者联系读者入群获取进阶项目文件!

二、原理介绍

官方代码地址: 官方论文地址点击此处即可跳转-阅读需要购买.

官方论文地址: 官方代码地址点击此处即可跳转

DICAM (Deep Inception and Channel-wise Attention Modules) 是一种基于深度学习的水下图像增强方法,旨在解决水下图像中常见的两大问题: 比例退化 和 不均匀光衰减 。该方法通过多层次的特征提取与自适应融合策略,显著提高水下图像的质量、对比度和色彩丰富度。下面是DICAM的核心机制和工作流程:

1. 多尺度通道特征提取(Inception模块) :

目标 :提取图像中每个颜色通道的特征,并同时处理与距离相关的比例退化、色彩丢失和色彩丰富度问题。

方法 :使用 Inception模块 ,该模块在不同尺度上提取图像特征,从而捕捉到图像中不同区域的色彩和内容退化信息。通过这种方式,DICAM能够适应水下图像中由于距离引起的不同退化率。

2. 通道注意力模块(CAM) :

目标 :对提取的特征进行加权,以突出不同通道和区域的关键特征,尤其是那些受比例退化和光衰减影响较大的部分。

方法 : CAM 根据图像各个通道和区域的退化比例,调整其重要性,使得颜色和内容信息能够得到有效恢复和增强。

3. 自适应融合与增强 :

目标 :通过自适应的方式融合不同通道和尺度的特征,进一步优化图像的色彩分布和对比度。

方法 :将提取的多尺度特征图通过CAM加权融合,改善水下图像的色彩均衡性和亮度,最终生成一个色彩丰富、视觉效果自然的增强图像。

4. 色彩修正阶段 :

目标 :在色彩修正阶段,通过特定的色彩校正策略进一步提高图像的色彩表现,确保增强后的图像在视觉上更加自然和真实。

方法 :利用CAM对色彩进行优化,确保图像在水下环境中的色彩偏差得到有效修复,增强图像的视觉效果。

结论:DICAM模型通过多尺度通道特征提取与通道注意力机制相结合,能够有效地提升水下图像的质量,特别是在颜色丰富度、对比度和色彩偏差修正方面。实验结果表明,DICAM在水下图像增强方面表现出了明显的优越性,尤其是在改善水下图像的颜色分布和细节恢复上。

以上内容均为论文提取,作者不对其真实性负责!

三、核心代码

核心代码的使用方式看章节四!

- import torch.nn as nn

- import torch

- __all__ = ['DICAM']

- class Inc(nn.Module):

- def __init__(self, in_channels, filters):

- super(Inc, self).__init__()

- self.branch1 = nn.Sequential(

- nn.Conv2d(in_channels=in_channels, out_channels=filters, kernel_size=(1, 1), stride=(1, 1), dilation=1,

- padding=(1 - 1) // 2),

- nn.LeakyReLU(),

- nn.Conv2d(in_channels=filters, out_channels=filters, kernel_size=(3, 3), stride=(1, 1), dilation=1,

- padding=(3 - 1) // 2),

- nn.LeakyReLU(),

- )

- self.branch2 = nn.Sequential(

- nn.Conv2d(in_channels=in_channels, out_channels=filters, kernel_size=(1, 1), stride=(1, 1), dilation=1,

- padding=(1 - 1) // 2),

- nn.LeakyReLU(),

- nn.Conv2d(in_channels=filters, out_channels=filters, kernel_size=(5, 5), stride=(1, 1), dilation=1,

- padding=(5 - 1) // 2),

- nn.LeakyReLU(),

- )

- self.branch3 = nn.Sequential(

- nn.MaxPool2d(kernel_size=(3, 3), stride=(1, 1), padding=1),

- nn.Conv2d(in_channels=in_channels, out_channels=filters, kernel_size=(1, 1), stride=(1, 1), dilation=1),

- nn.LeakyReLU(),

- )

- self.branch4 = nn.Sequential(

- nn.Conv2d(in_channels=in_channels, out_channels=filters, kernel_size=(1, 1), stride=(1, 1), dilation=1),

- nn.LeakyReLU(),

- )

- def forward(self, input):

- o1 = self.branch1(input)

- o2 = self.branch2(input)

- o3 = self.branch3(input)

- o4 = self.branch4(input)

- return torch.cat([o1, o2, o3, o4], dim=1)

- class Flatten(nn.Module):

- def forward(self, inp):

- return inp.view(inp.size(0), -1)

- class CAM(nn.Module):

- def __init__(self, in_channels, reduction_ratio):

- super(CAM, self).__init__()

- self.module = nn.Sequential(

- nn.AdaptiveAvgPool2d((1, 1)),

- Flatten(),

- nn.Linear(in_channels, in_channels // reduction_ratio),

- nn.Softsign(),

- nn.Linear(in_channels // reduction_ratio, in_channels),

- nn.Softsign()

- )

- def forward(self, input):

- return input * self.module(input).unsqueeze(2).unsqueeze(3).expand_as(input)

- class DICAM(nn.Module):

- def __init__(self, x): # 输入必须是三通道.

- super(DICAM, self).__init__()

- self.layer_1_r = Inc(in_channels=1, filters=64)

- self.layer_1_g = Inc(in_channels=1, filters=64)

- self.layer_1_b = Inc(in_channels=1, filters=64)

- self.layer_2_r = CAM(256, 4)

- self.layer_2_g = CAM(256, 4)

- self.layer_2_b = CAM(256, 4)

- self.layer_3 = Inc(768, 64)

- self.layer_4 = CAM(256, 4)

- self.layer_tail = nn.Sequential(

- nn.Conv2d(in_channels=256, out_channels=24, kernel_size=(3, 3), stride=(1, 1), padding=(3 - 1) // 2),

- nn.LeakyReLU(),

- nn.Conv2d(in_channels=24, out_channels=3, kernel_size=(1, 1), stride=(1, 1), padding=(1 - 1) // 2),

- nn.Sigmoid()

- )

- def forward(self, input):

- input_r = torch.unsqueeze(input[:, 0, :, :], dim=1)

- input_g = torch.unsqueeze(input[:, 1, :, :], dim=1)

- input_b = torch.unsqueeze(input[:, 2, :, :], dim=1)

- layer_1_r = self.layer_1_r(input_r)

- layer_1_g = self.layer_1_g(input_g)

- layer_1_b = self.layer_1_b(input_b)

- layer_2_r = self.layer_2_r(layer_1_r)

- layer_2_g = self.layer_2_g(layer_1_g)

- layer_2_b = self.layer_2_b(layer_1_b)

- layer_concat = torch.cat([layer_2_r, layer_2_g, layer_2_b], dim=1)

- layer_3 = self.layer_3(layer_concat)

- layer_4 = self.layer_4(layer_3)

- output = self.layer_tail(layer_4)

- return output

- if __name__ == '__main__':

- from thop import profile, clever_format

- inp1= torch.rand(1,64,256,256)

- model = DICAM()

- out = model(inp1)

- print(out.shape)

四、添加教程

4.1 修改一

第一还是建立文件,我们找到如下ultralytics/nn文件夹下建立一个目录名字呢就是'Addmodules'文件夹( 用群内的文件的话已经有了无需新建) !然后在其内部建立一个新的py文件将核心代码复制粘贴进去即可。

4.2 修改二

第二步我们在该目录下创建一个新的py文件名字为'__init__.py'( 用群内的文件的话已经有了无需新建) ,然后在其内部导入我们的检测头如下图所示。

4.3 修改三

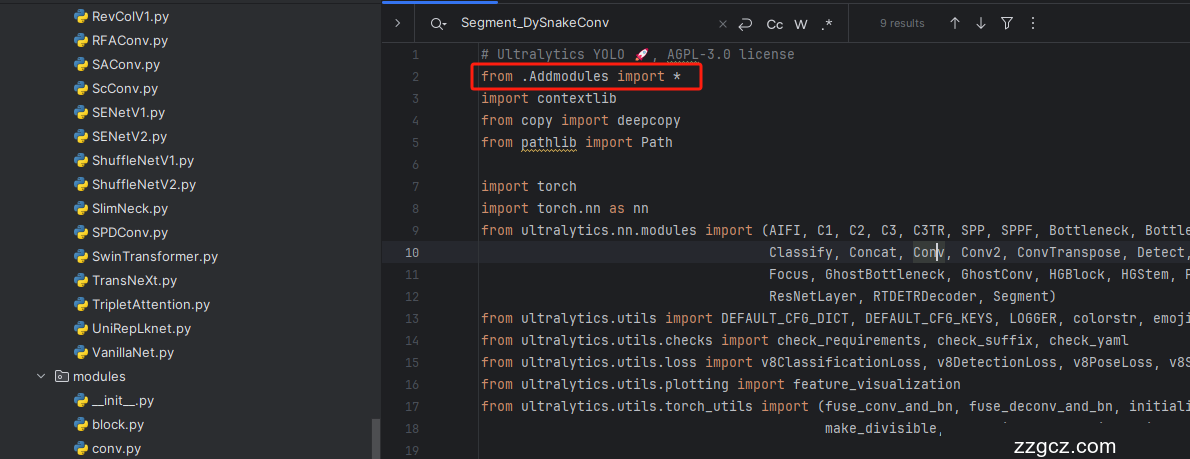

第三步找到如下文件'ultralytics/nn/tasks.py'进行导入和注册我们的模块( 用群内的文件的话已经有了无需重新导入直接开始第四步即可) !

4.4 修改四

找到文件到如下文件'ultralytics/nn/tasks.py',在其中的parse_model方法中添加即可。

到此就修改完成了,大家可以复制下面的yaml文件运行,

如果不会添加可联系作者入群观看视频教程。

五、正式训练

5.1 yaml文件1

训练信息:YOLO11-DICAM summary: 429 layers, 2,654,165 parameters, 2,654,149 gradients, 51.1 GFLOPs

# 我发现最近这个图像增强的算法不配合loss确实难有效果,后面我会把yolo的loss分开计算不过需要一些设计的时间.

- # Ultralytics YOLO 🚀, AGPL-3.0 license

- # YOLO11 object detection model with P3-P5 outputs. For Usage examples see https://docs.ultralytics.com/tasks/detect

- # Parameters

- nc: 80 # number of classes

- scales: # model compound scaling constants, i.e. 'model=yolo11n.yaml' will call yolo11.yaml with scale 'n'

- # [depth, width, max_channels]

- n: [0.50, 0.25, 1024] # summary: 319 layers, 2624080 parameters, 2624064 gradients, 6.6 GFLOPs

- s: [0.50, 0.50, 1024] # summary: 319 layers, 9458752 parameters, 9458736 gradients, 21.7 GFLOPs

- m: [0.50, 1.00, 512] # summary: 409 layers, 20114688 parameters, 20114672 gradients, 68.5 GFLOPs

- l: [1.00, 1.00, 512] # summary: 631 layers, 25372160 parameters, 25372144 gradients, 87.6 GFLOPs

- x: [1.00, 1.50, 512] # summary: 631 layers, 56966176 parameters, 56966160 gradients, 196.0 GFLOPs

- # YOLO11n backbone

- backbone:

- # [from, repeats, module, args]

- - [-1, 1, DICAM, []] # 0-P1/2

- - [-1, 1, Conv, [64, 3, 2]] # 1-P1/2

- - [-1, 1, Conv, [128, 3, 2]] # 2-P2/4

- - [-1, 2, C3k2, [256, False, 0.25]]

- - [-1, 1, Conv, [256, 3, 2]] # 4-P3/8

- - [-1, 2, C3k2, [512, False, 0.25]]

- - [-1, 1, Conv, [512, 3, 2]] # 6-P4/16

- - [-1, 2, C3k2, [512, True]]

- - [-1, 1, Conv, [1024, 3, 2]] # 8-P5/32

- - [-1, 2, C3k2, [1024, True]]

- - [-1, 1, SPPF, [1024, 5]] # 10

- - [-1, 2, C2PSA, [1024]] # 11

- # YOLO11n head

- head:

- - [-1, 1, nn.Upsample, [None, 2, "nearest"]]

- - [[-1, 7], 1, Concat, [1]] # cat backbone P4

- - [-1, 2, C3k2, [512, False]] # 14

- - [-1, 1, nn.Upsample, [None, 2, "nearest"]]

- - [[-1, 5], 1, Concat, [1]] # cat backbone P3

- - [-1, 2, C3k2, [256, False]] # 17 (P3/8-small)

- - [-1, 1, Conv, [256, 3, 2]]

- - [[-1, 14], 1, Concat, [1]] # cat head P4

- - [-1, 2, C3k2, [512, False]] # 20 (P4/16-medium)

- - [-1, 1, Conv, [512, 3, 2]]

- - [[-1, 11], 1, Concat, [1]] # cat head P5

- - [-1, 2, C3k2, [1024, True]] # 23 (P5/32-large)

- - [[17, 20, 23], 1, Detect, [nc]] # Detect(P3, P4, P5)

5.2 训练代码

大家可以创建一个py文件将我给的代码复制粘贴进去,配置好自己的文件路径即可运行。

- import warnings

- warnings.filterwarnings('ignore')

- from ultralytics import YOLO

- if __name__ == '__main__':

- model = YOLO('替换你的模型配置文件yaml文件地址')

- # 如何切换模型版本, 上面的ymal文件可以改为 yolov11s.yaml就是使用的v11s,

- # 类似某个改进的yaml文件名称为yolov11-XXX.yaml那么如果想使用其它版本就把上面的名称改为yolov11l-XXX.yaml即可(改的是上面YOLO中间的名字不是配置文件的)!

- # model.load('yolo11n.pt') # 是否加载预训练权重,科研不建议大家加载否则很难提升精度

- model.train(data=r"替换你的数据集配置文件地址",

- # 如果大家任务是其它的'ultralytics/cfg/default.yaml'找到这里修改task可以改成detect, segment, classify, pose

- cache=False,

- imgsz=640,

- epochs=150,

- single_cls=False, # 是否是单类别检测

- batch=16,

- close_mosaic=0,

- workers=0,

- device='0',

- optimizer='SGD', # using SGD

- # resume='runs/train/exp21/weights/last.pt', # 如过想续训就设置last.pt的地址

- amp=False, # 如果出现训练损失为Nan可以关闭amp

- project='runs/train',

- name='exp',

- )

5.3 训练过程截图

五、本文总结

到此本文的正式分享内容就结束了,在这里给大家推荐我的YOLOv11改进有效涨点专栏,本专栏目前为新开的平均质量分98分,后期我会根据各种最新的前沿顶会进行论文复现,也会对一些老的改进机制进行补充,如果大家觉得本文帮助到你了,订阅本专栏,关注后续更多的更新~